Chapter 2. The Loss of Judgment: Human Agency Threatened by AI Reliance

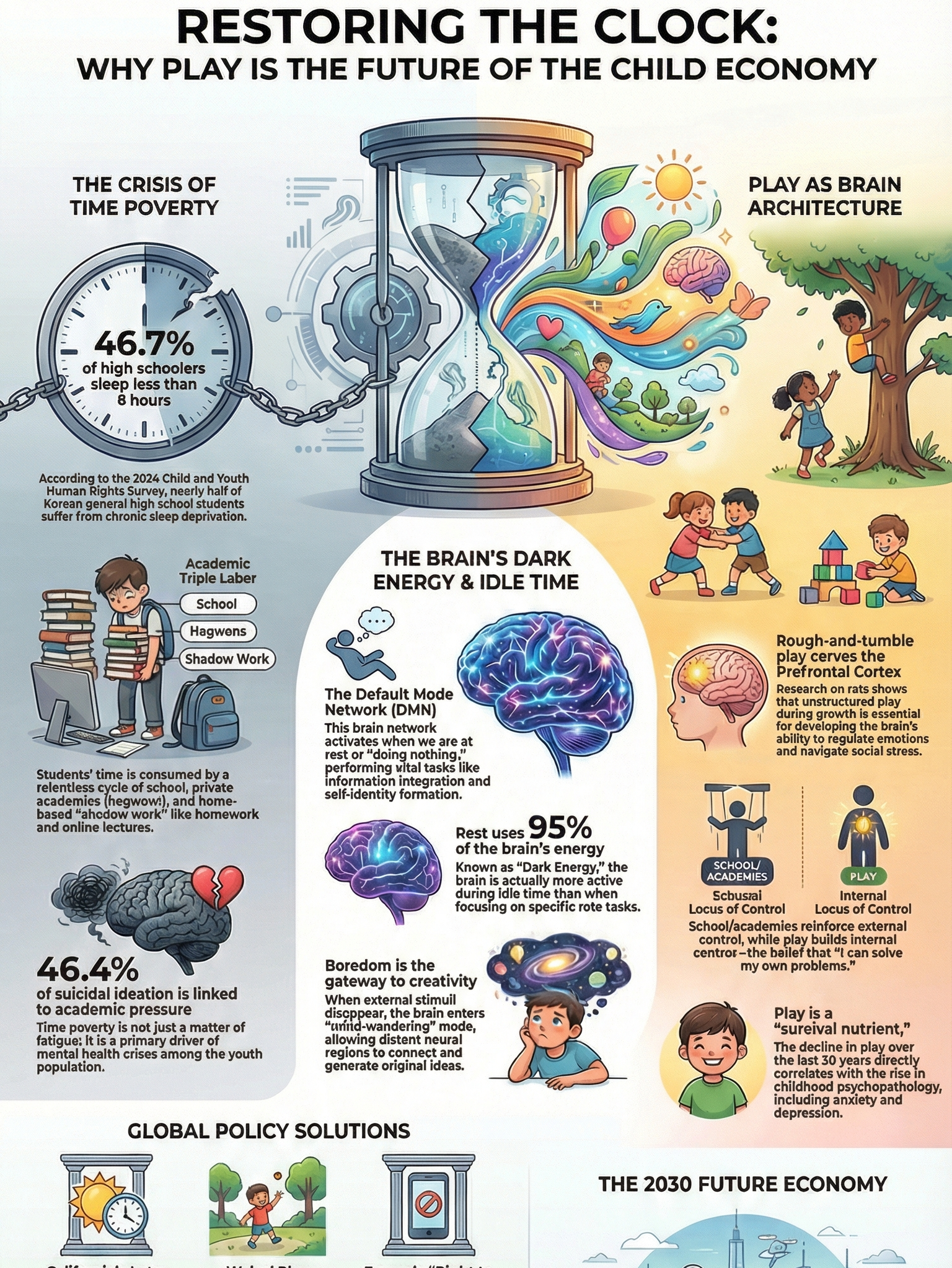

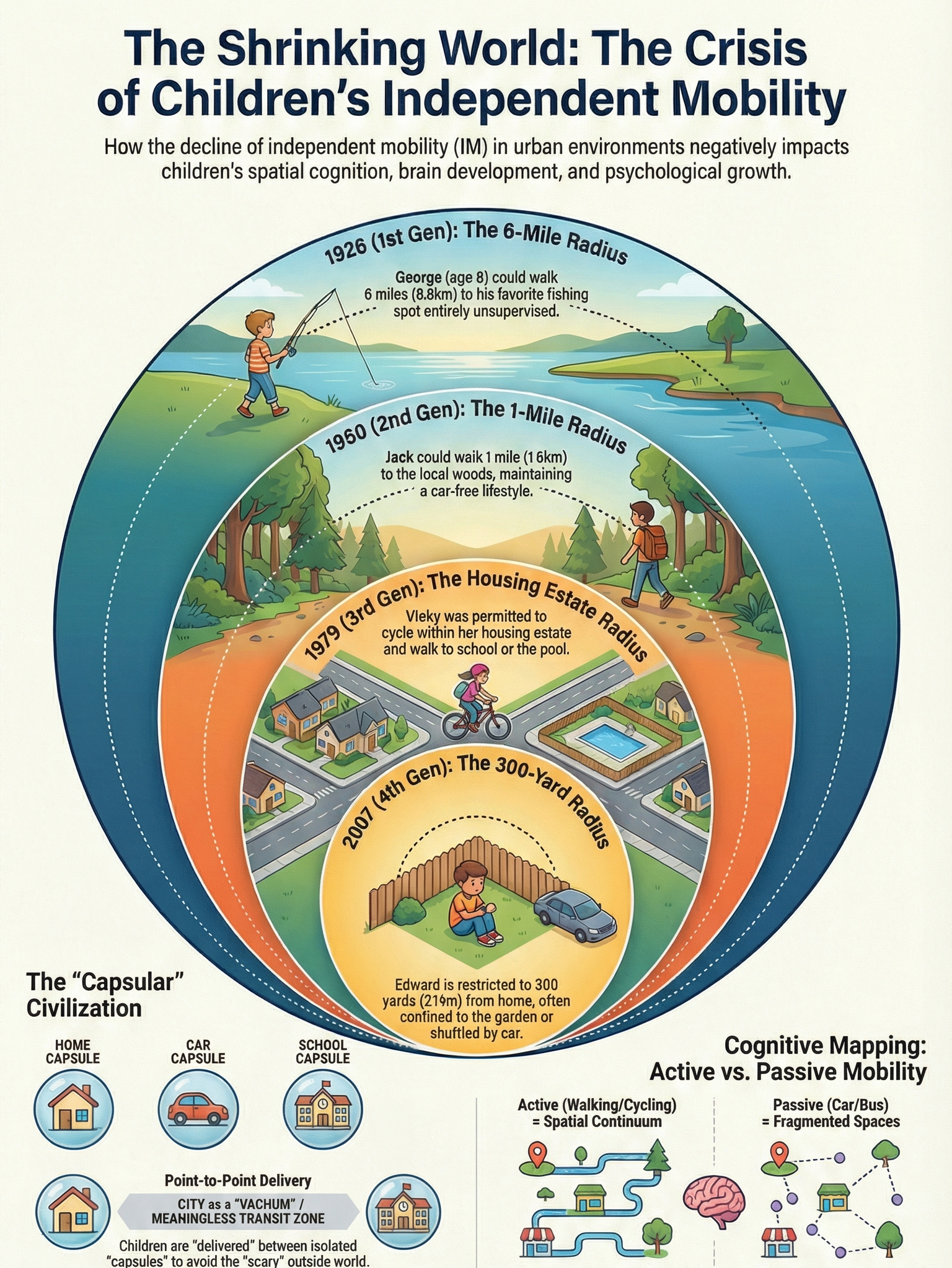

I. The Trap of Cognitive Outsourcing: Human Functions Stolen by Tools

1.1. Historical Repetition: Technological Convenience and the Atrophy of Body and Intellect The development of tools in human civilization has inevitably accompanied "Cognitive Offloading," the transfer of specific human abilities to external sources. Just as the spread of automobiles reduced human walking ability, and the advent of mobile phones took away the memory capacity to memorize hundreds of phone numbers, GPS navigation has weakened the ability to explore paths and structure space independently. While these tools increased the efficiency of specific tasks, they simultaneously rendered the neural networks performing those functions idle, causing cognitive atrophy.

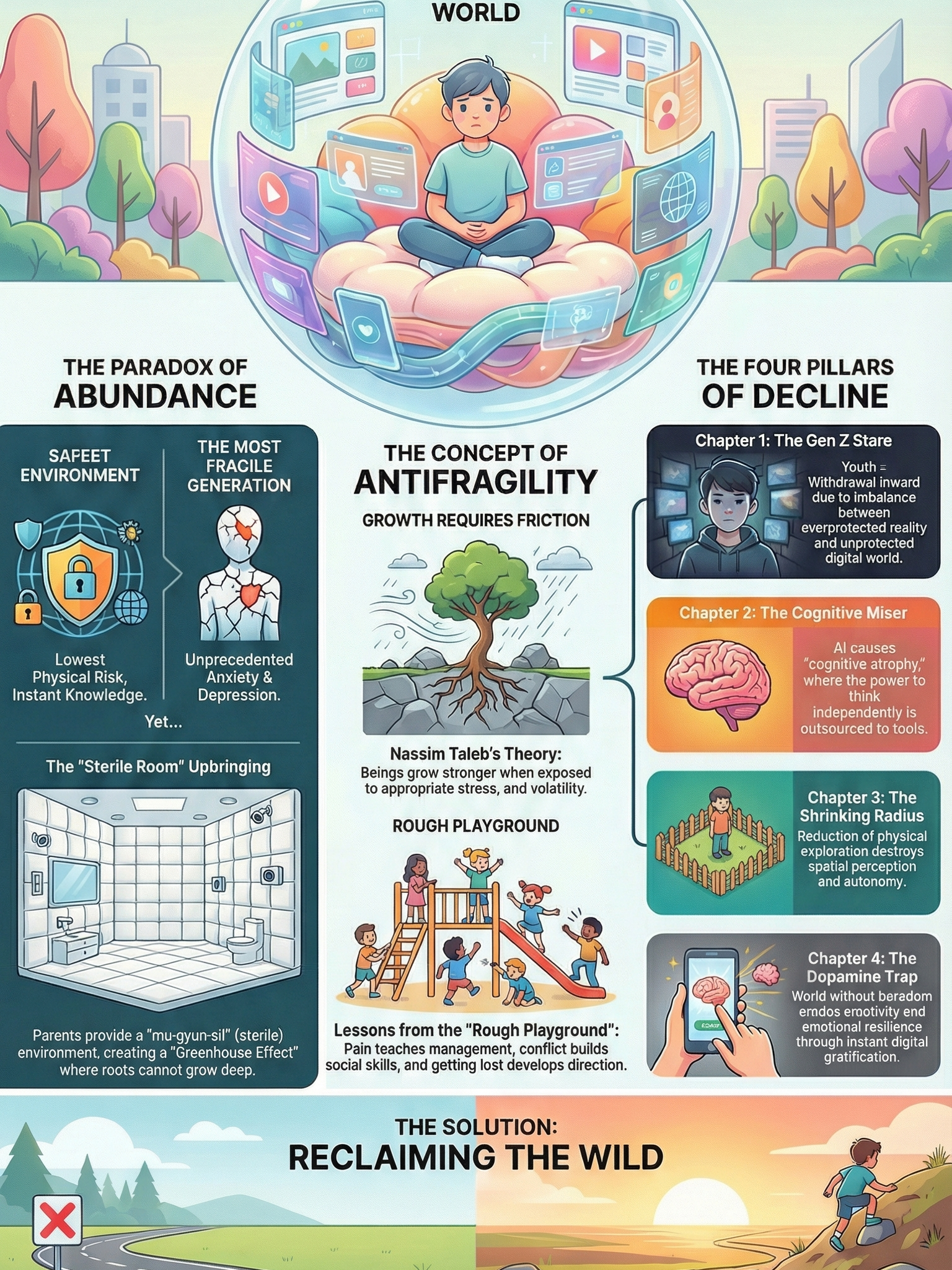

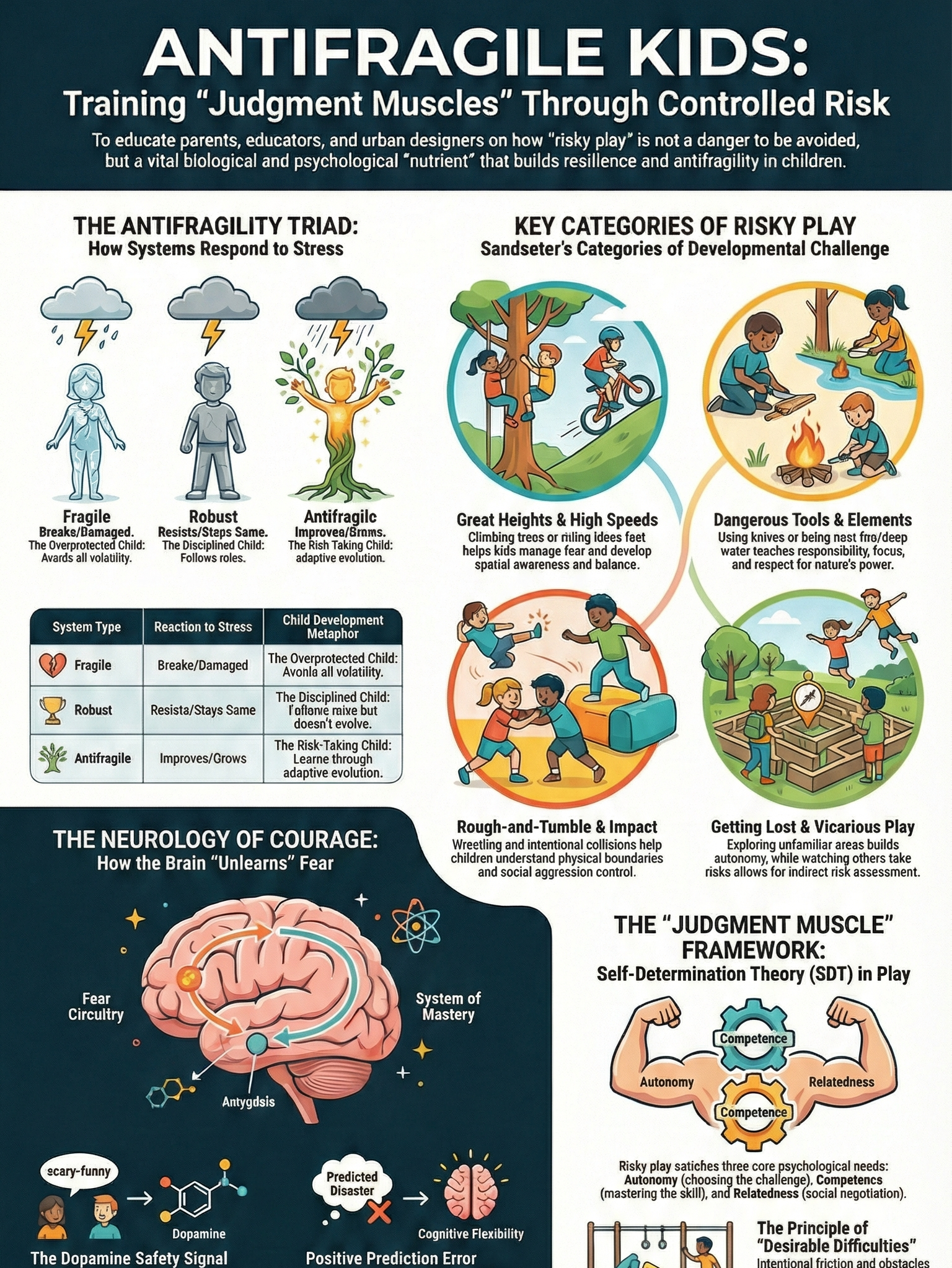

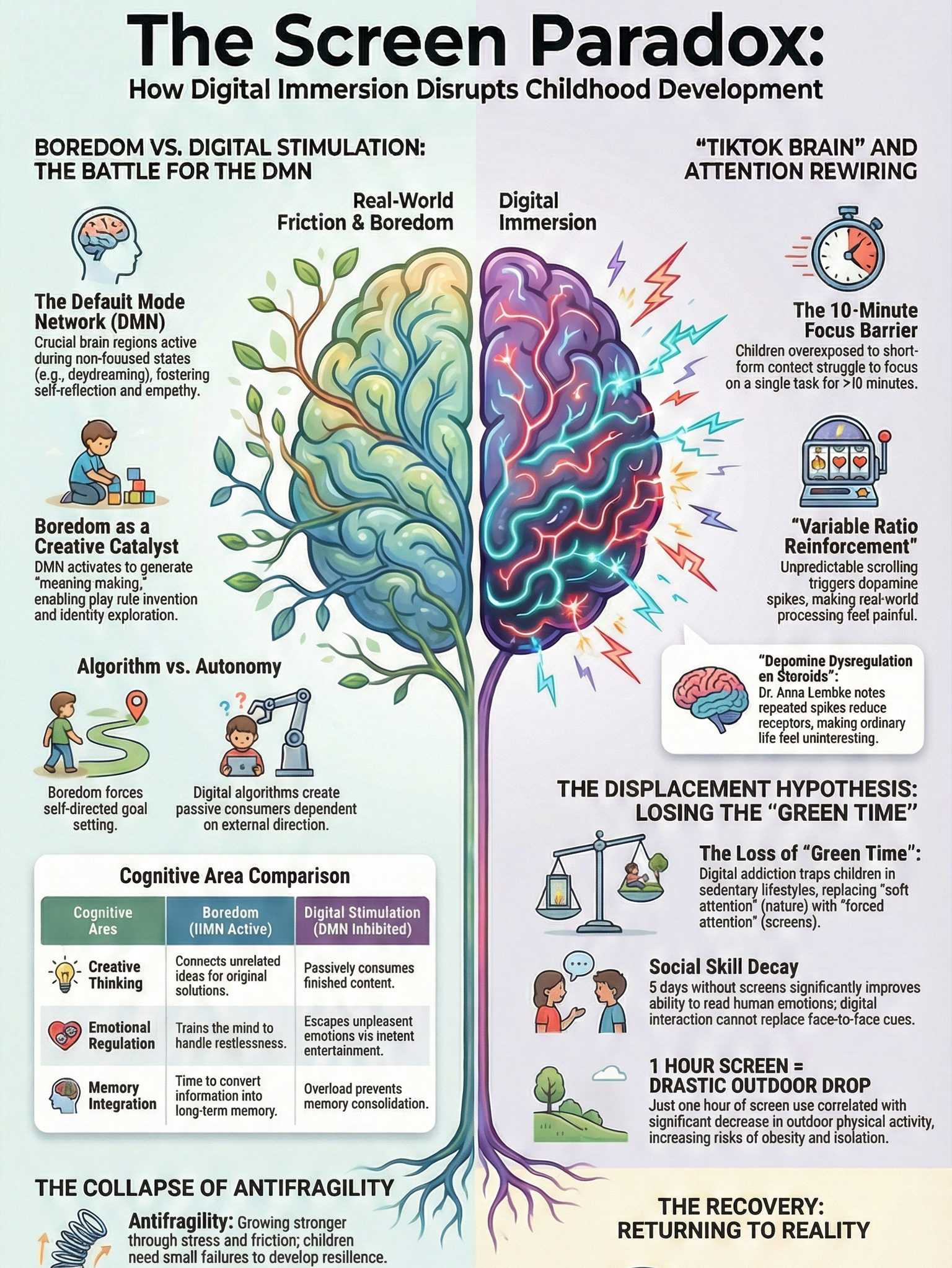

1.2. The 'Distributed Atrophy 2.0' Model: The Transfer of Thinking Processes The recently proposed "Distributed Atrophy 2.0" model warns that modern Artificial Intelligence (AI) poses a qualitatively different threat compared to tools of the past. While past technologies assisted with "results" such as memory or calculation, generative AI and decision-making algorithms replace the human "reasoning process" itself. Humans possess the characteristic of being "Cognitive Misers" who try to conserve energy; as they become accustomed to the immediate answers provided by AI, they avoid the painful process of abstracting concepts and assembling logic on their own. This habitual reliance eventually leads to a general erosion of critical thinking and problem-solving skills.

II. Algorithmic Optimization vs. Human Uniqueness

2.1. Uniformity in the Name of 'The Best' The core logic of AI systems is "Optimization" and "Efficiency" based on data. Algorithms present the statistically most probable correct answer among countless cases, but there is no single "correct answer" that applies to everyone in the myriad choices faced in human life. This is because the value of life is formed subjectively according to each individual's unique context and values. A life that conforms to the "optimal decisions" made by AI may be efficient, but there is a high risk that the unique tastes and distinctive life narratives possessed by individuals will be buried under the algorithm's average values.

2.2. The Absence of Embodied Intelligence Philosopher Hubert Dreyfus argued that human intelligence is based not merely on the ability to manipulate symbols, but on "Skilled Coping" and intuition gained by colliding with the world through a physical body. AI can mimic vast amounts of data, but it cannot possess the contextual understanding and insights containing the "weight of life" gained through actual human experience. While AI can provide information, the process of "Insight"—realizing what that information means in one's own life—is a subjective realm that only humans can perform.

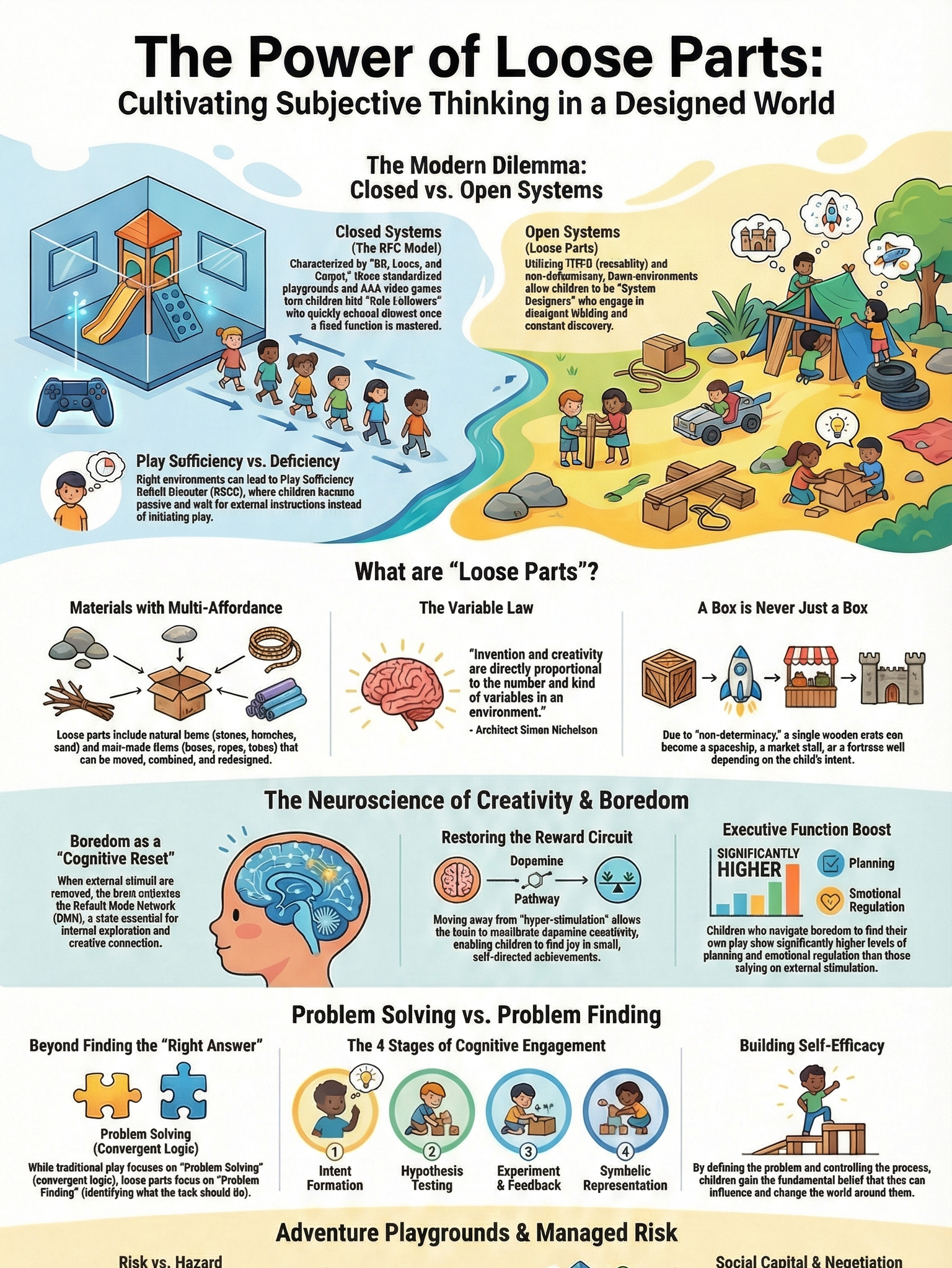

III. The Value of Inefficiency: The Self Completed Through Failure

3.1. 'Desirable Difficulties' and Self-Efficacy From a psychological perspective, human growth occurs in the process of overcoming "Desirable Difficulties". Answers obtained immediately without friction do not transfer to long-term memory and only create an illusion of learning. Conversely, painful trial and error and failure strengthen the synaptic connections in the brain and form the foundation for a strong sense of "Self-Efficacy," the belief that one can solve problems. An environment where AI removes all friction deprives children of the joy of such achievements and opportunities for self-expansion.

3.2. The IKEA Effect and Identity Formation Humans demonstrate the "IKEA Effect," assigning higher value to results into which they have poured their own effort. The "inefficient times" spent assembling furniture, getting lost, and resolving conflicts come together to construct the unique identity of "my life". Delegating all judgments and actions to efficient AI is paradoxically equivalent to giving up the labor that makes one's life meaningful. Failure and inefficiency are not waste, but essential costs humans must pay to acquire a unique self.

IV. The Outsourcing of Responsibility: Deception in the Name of Technology

4.1. Existential Freedom and the Avoidance of Responsibility According to Jean-Paul Sartre's existentialism, humans are condemned to the "penalty of freedom," meaning they must take responsibility for all their choices. The belief that AI's judgments are objective and neutral can become a means of "Bad Faith," allowing individuals to avoid the moral weight accompanying their decisions. The excuse that "I chose it because AI recommended it" is an act of abandoning subjective judgment and degrading oneself into a component subject to the environment.

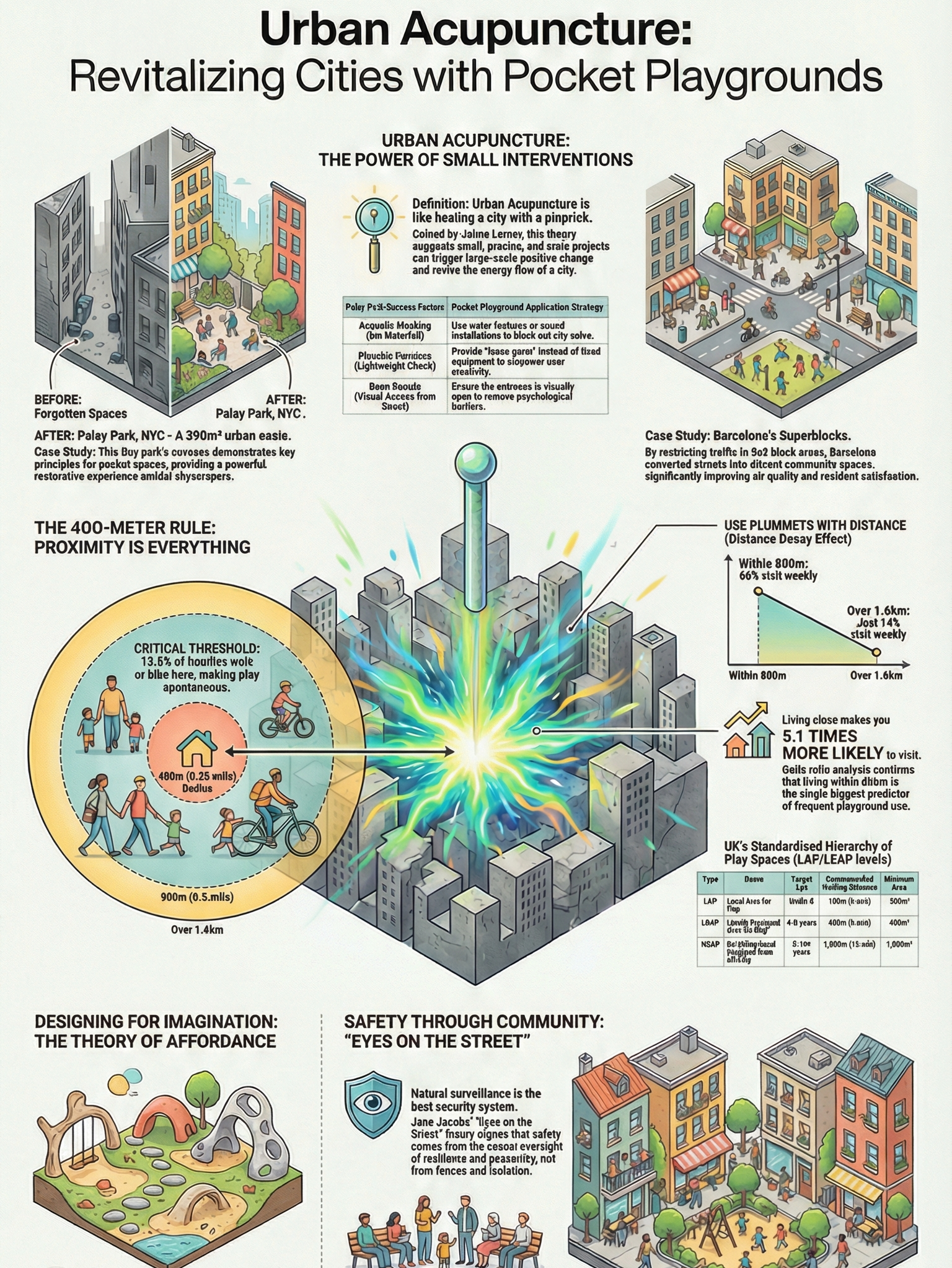

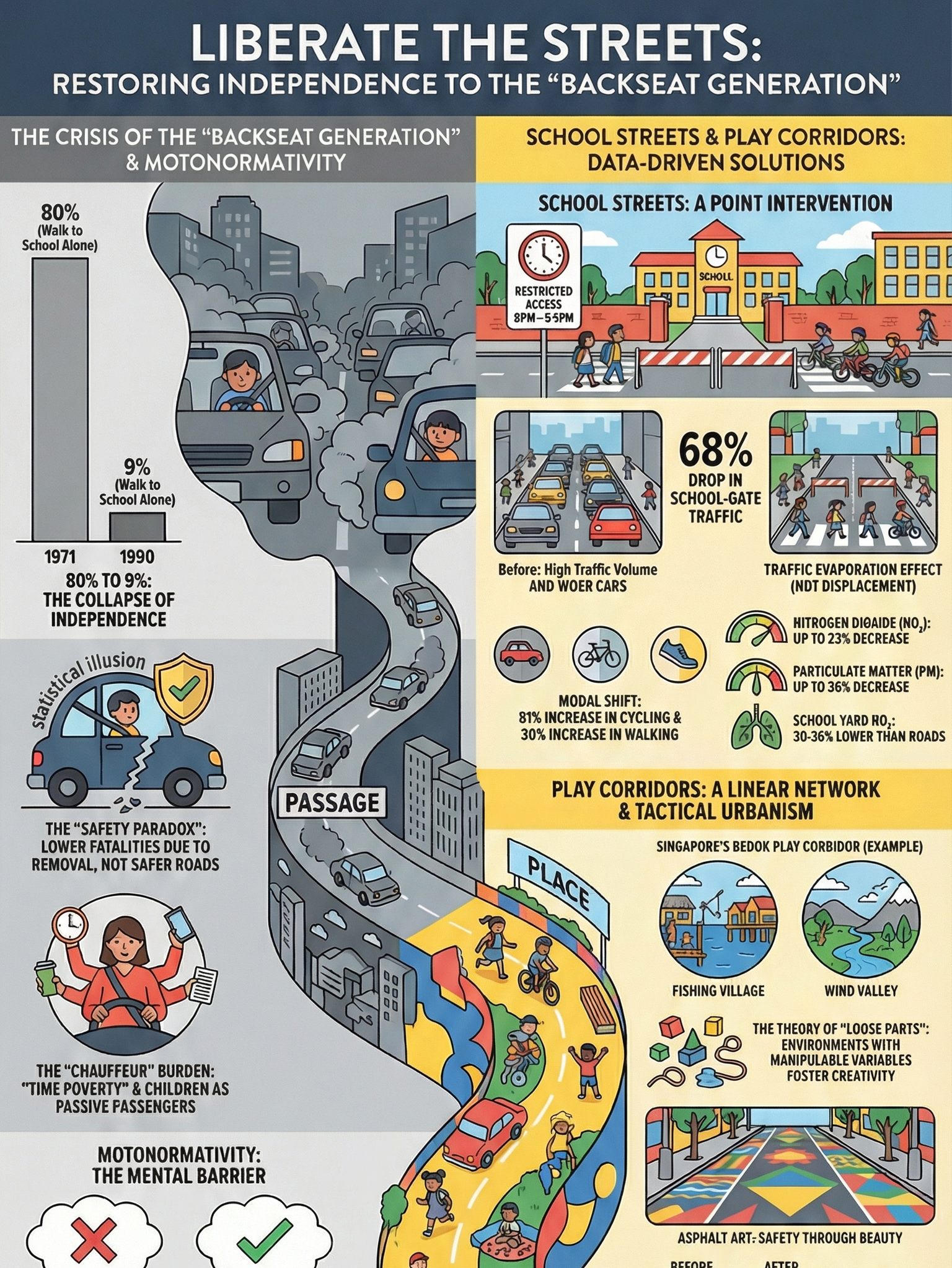

4.2. The Loss of Cognitive Sovereignty and an Alternative Future When delegating all judgments to algorithms, humans fall from being sovereigns of life to managed "resources". A generation that has lost the ability to think for itself cannot detect AI errors or imagine alternatives outside the path set by technology. Therefore, our vision of providing a "15-minute play city" where children collide with friends and fail is not simply a regression to the past. It is the most powerful future strategy to cultivate humans equipped with "Cognitive Sovereignty" who can wield technology as a tool, rather than being subordinate to it in the coming AI era.

4.3. Conclusion of Chapter 2: Restoring a Subjective Life Beyond Efficiency In conclusion, protecting human agency in the AI era lies not in blindly trusting technological efficiency but in intentionally cultivating the "power to think." Human uniqueness is finally completed amidst the agony and choices that algorithms cannot calculate, and the full responsibility for those results. The efficiency gained in exchange for giving up cognitive sovereignty is merely a soulless convenience, and we must choose the arduous path of subjectivity—constantly questioning and judging for ourselves.

제2장. 편안함의 역습: AI라는 지팡이와 퇴화하는 뇌

1. 도구인가, 대리인인가: '인지적 발판'에서 '지팡이'로

인류의 역사는 곧 도구의 역사였다. 4,500년 전 수메르인은 복잡한 계산을 위해 주판을 들었고, 우리는 기억의 한계를 넘기 위해 문자를 발명했다. 지금까지의 도구는 인간이 더 높이 도약할 수 있도록 돕는 **'인지적 발판(Cognitive Scaffold)'**이었다. 발판을 딛고 선 인간은 자신의 신체적, 지적 한계를 확장해 왔다.

하지만 생성형 AI의 등장은 이 오랜 도구의 정의를 뿌리째 흔들고 있다. AI는 단순한 계산이나 기억 보조를 넘어, 인간이 해야 할 '사고 프로세스' 자체를 대신 수행한다. 이것은 더 이상 발판이 아니다. 인간이 스스로 걷는 법을 잊게 만드는 **'인지적 지팡이(Cognitive Crutch)'**에 가깝다. 우리는 지금 효율성이라는 달콤한 명분 아래, 스스로 생각하고 판단하는 주체성을 기계에 외주화하고 있다.

2. 생각하지 않는 뇌: '인지적 구두쇠'의 함정

인간의 뇌는 본래 에너지를 아끼려는 본능, 즉 '인지적 구두쇠(Cognitive Miser)' 기질을 가지고 있다. 골치 아픈 문제를 만났을 때, AI가 단 몇 초 만에 매끄러운 답을 내놓는다면 뇌는 기꺼이 생각하기를 멈춘다.

이러한 '인지적 오프로딩(Cognitive Offloading)'이 가속화될 때 발생하는 문제는 명확하다. 바로 **'사용하지 않으면 잃는다(Use it or lose it)'**는 생물학적 법칙이다.

가장 극적인 사례는 내비게이션이다. 런던의 택시 운전사들은 복잡한 시내 지리를 머릿속에 그리는 훈련을 통해 해마(기억과 공간 지각을 담당하는 뇌 부위)가 일반인보다 비대하게 발달했다. 반면, GPS의 지시만 맹목적으로 따르는 현대인의 뇌에서는 이러한 공간 인지 능력이 점차 퇴화한다. AI가 답을 떠먹여 주는 환경에서, 우리의 비판적 사고력과 문제 해결 능력 또한 같은 운명을 맞이할 위기에 처해 있다.

3. 불편함의 가치: 성장은 마찰에서 온다

그렇다면 우리는 왜 굳이 힘들게 머리를 써야 하는가? 심리학은 그 답을 **'바람직한 어려움(Desirable Difficulties)'**에서 찾는다.

근육이 찢어지는 듯한 저항을 견뎌야 더 강해지듯, 뇌 또한 적절한 인지적 부하와 씨름할 때 비로소 성장한다. 쉽게 얻은 지식은 모래성처럼 금방 흩어지지만, 고통스러운 시행착오 끝에 얻은 깨달음은 뇌의 시냅스를 단단하게 연결한다. 이것이 바로 학습의 본질이다.

우리가 직접 조립한 가구에 더 큰 애착을 느끼는 **'이케아 효과(IKEA Effect)'**는 지적 활동에도 그대로 적용된다. 스스로 고민하고, 길을 잃고, 다시 답을 찾아가는 비효율적인 과정 속에서 우리는 '나만의 관점'과 '통찰'을 얻는다. AI가 모든 마찰을 제거해 준 매끄러운 세상에서 아이들은 실패를 통한 성취감, 즉 "내가 해냈다"는 자기 효능감을 맛볼 기회를 박탈당하고 있다.

4. 결론: '비효율'을 선택할 용기

AI는 방대한 데이터를 흉내 낼 수는 있어도, 인간이 삶의 무게를 견디며 얻어낸 맥락적 이해와 직관은 가질 수 없다. 정보는 AI가 줄 수 있지만, 통찰은 오직 인간의 몫이다.

이제 우리는 의식적으로 '불편함'을 선택해야 하는 시점에 와 있다. AI의 추천 버튼을 누르기 전에 한 번 더 고민하고, 내비게이션 없이 길을 찾아보고, 요약본 대신 두꺼운 책을 읽는 '비효율'을 감수해야 한다.

기술의 편리함에 기대어 뇌를 '절전 모드'로 두지 말자. 거친 현실과 부딪히며 얻는 상처와 굳은살만이, AI 시대에 우리를 대체 불가능한 존재로 만들어줄 유일한 무기이기 때문이다.

판단의 상실: AI 의존으로 위협받는 인간의 주체성

인공지능(AI) 기술의 급격한 확산은 인류의 지적 활동 전반에 걸쳐 유례없는 대전환을 예고하고 있습니다. 과거의 도구들이 인간의 신체적 한계를 보완하거나 특정 지적 작업을 보조하는 '인지적 발판'의 역할을 수행했다면, 현대의 생성형 AI와 의사결정 알고리즘은 인간의 '사고 프로세스' 자체를 대체하는 '인지적 지팡이'로 변모하고 있습니다.1 이러한 변화는 단순한 효율성의 증대를 넘어, 스스로 생각하고 판단하는 인간 고유의 주체성을 근본적으로 위협하는 인지적 위축과 존재론적 위기를 초래하고 있습니다. 본 보고서는 AI 의존이 인간의 비판적 사고, 기억력, 공간 지각력 등 핵심 인지 능력에 미치는 부정적 영향을 분석하고, 비효율성과 실패를 통해 획득되는 '경험'의 가치가 인간 주체성 형성에 어떠한 필수적 역할을 하는지 심층적으로 고찰하고자 합니다.

인지적 오프로딩의 역사적 진화와 현대적 변곡점

인간이 자신의 정신적 업무를 완화하기 위해 도구를 사용하는 '인지적 오프로딩(Cognitive Offloading)'은 인류 문명의 역사만큼이나 오래된 현상입니다.3 4,500년 전 수메르인들이 복잡한 산술 계산을 위해 주판을 사용하고, 문자의 발명을 통해 정보를 기록하기 시작한 것은 기억과 계산이라는 뇌의 부담을 외부로 전이시킨 초기 사례입니다.3 이러한 도구들은 인류가 모든 정보를 암기하거나 계산하는 데 소모하던 에너지를 더 고차원적인 창의적 활동과 사회적 소통에 집중할 수 있게 하는 긍정적인 효과를 가져왔습니다.3

그러나 1990년대 이후 디지털 기술의 폭발적 발전은 인지적 오프로딩의 양상을 근본적으로 바꾸어 놓았습니다. 인터넷의 보급과 모바일 기기의 일상화는 지식의 접근성을 극대화했으나, 동시에 정보를 내면화하기보다 정보가 위치한 '경로'만을 기억하는 이른바 '구글 효과(Google Effect)'를 낳았습니다.3 이러한 현상은 정보에 대한 깊은 통찰과 체계적 이해를 방해하며, 인지적 자원이 외부 도구에 종속되는 결과를 초래했습니다.3 특히 생성형 AI의 등장은 단순한 정보 검색을 넘어 논리적 추론과 요약, 심지어 가치 판단까지 기계에 맡기는 '사고의 외주화'를 가속화하고 있습니다.5

인지적 오프로딩의 역사적 발전 단계

시대

주요 도구

오프로딩의 성격

인지적 영향

고대

주판, 문자

기억 및 기본 계산의 저장

구전 전통의 약화, 기록 기반 지식 축적 3

산업화 시대

계산기, 인쇄기

복잡한 수식 및 대량 정보 전파

수리 능력의 외주화, 전문 지식의 대중화 3

초기 디지털

검색 엔진, GPS

정보 위치 및 공간 경로 기억

'구글 효과', 공간 기억력 및 의미론적 지식 감퇴 4

인공지능 시대

LLM, 의사결정 알고리즘

추론, 요약, 가치 판단의 대체

분산된 위축, 비판적 사고 및 추상화 능력의 침식 5

현대인들이 겪고 있는 자동차와 걷기, 휴대전화와 암기력, 지도 앱과 길 찾기 능력의 쇠퇴는 AI 의존으로 인한 인지적 능력 상실의 전조 증상에 불과합니다.5 인지적 오프로딩이 과도해질 때 뇌는 사용하지 않는 기능을 퇴화시키는 '신경 가소성'의 원리에 따라 작동하며, 이는 결국 '디지털 치매' 가설로 이어지는 심각한 인지적 위기를 야기할 수 있습니다.1

분산된 위축 모델: 인지 능력 상실의 메커니즘

최근 학계에서 제안된 '분산된 위축 2.0(Distributed Atrophy 2.0)' 모델은 대규모 언어 모델(LLM)에 대한 습관적 의존이 인간의 인지 체계를 어떻게 재구성하고 파괴하는지 상세히 설명합니다.5 인간은 본래 에너지를 아끼려는 '인지적 구두쇠(Cognitive Miser)'의 특성을 지니고 있어, 가장 적은 노력이 드는 경로를 선호합니다.5 AI가 제공하는 매끄럽고 즉각적인 답변은 사고 과정에서 발생하는 '표상적 긴장(Representational Strain)'을 제거함으로써 뇌가 스스로 추론하고 합성하는 과정을 회피하게 만듭니다.5

이 모델은 인지적 위축이 다음과 같은 4단계의 연쇄 반응을 통해 일어난다고 분석합니다 5:

인지적 오프로딩의 고착화: 문제 해결을 위해 스스로 생각하기보다 AI에 질문하는 행위가 습관이 됩니다.

표상적 긴장의 감소: 스스로 개념을 정의하고 구조화할 때 발생하는 고통스러운 사고 과정이 사라집니다. 이는 마치 근육을 사용하지 않을 때 발생하는 물리적 퇴화와 유사합니다.

내부 추상화 능력의 불용: 구체적인 사례에서 보편적인 원리를 추출하거나 복잡한 정보를 통합하는 능력이 약화됩니다.

표상적 위축 및 의존성 증대: 인지 능력이 구조적으로 약해지며, 도구 없이는 기본적인 판단조차 내리기 힘든 상태에 도달합니다.

이러한 위축은 단순한 지능의 저하가 아니라 '자기 신뢰(Self-trust)'의 붕괴로 이어집니다.5 연구에 따르면 외부 시스템에 대한 접근 가능성이 예상될 때, 사람들은 실제 지식 유무와 상관없이 자신의 능력을 의심하며 "모르겠다"고 답하는 경향이 강화됩니다.5 이는 메타인지적 발판이 얇아지면서 사고의 주권이 알고리즘으로 전이되고 있음을 시사합니다.5

비판적 사고의 쇠퇴와 기술적 평준화의 역설

AI의 활용이 비판적 사고력에 미치는 영향에 대한 실증적 연구들은 일관된 경고를 보내고 있습니다.6 MIT 미디어 랩의 연구와 여러 학술적 분석에 따르면, AI 도구에 대한 과도한 의존은 독립적인 추론 능력을 감소시키고 사용자들을 수동적인 정보 소비자료 전락시킵니다.6 특히 젊은 층일수록 AI에 대한 의존도가 높고 비판적 사고 점수가 낮게 나타나는 경향이 뚜렷합니다.7

직업적 영역에서도 이러한 '탈숙련화(Deskilling)' 현상이 관찰됩니다.10 AI는 하위 숙련자들이 전문가 수준의 성과를 낼 수 있도록 돕는 '평준화 효과(Levelling Effect)'를 발휘하지만, 동시에 사용자가 기초적인 개념을 학습하거나 시행착오를 통해 전문성을 쌓을 기회를 박탈합니다.11 이는 단기적인 생산성 향상에는 도움이 될 수 있으나, 장기적으로는 시스템의 오류를 감지하거나 창의적인 대안을 제시할 수 있는 고도의 전문 역량을 고갈시킵니다.12

AI 활용에 따른 비판적 사고 및 인지적 위축 비교 분석

분석 지표

AI 고의존 집단

AI 저의존/적정 활용 집단

인지적 함의

비판적 사고 점수

유의미하게 낮음 7

상대적으로 높음

습관적 오프로딩이 추론 능력을 침식함 8

정보 검증 의지

낮음 (알고리즘 편향 수용) 8

높음 (독립적 검증 수행)

기술에 대한 과도한 신뢰가 회의론을 약화시킴 14

뇌 활성화 (EEG 측정)

낮은 인지적 몰입 및 언어적 수행 저하 14

활발한 신경 활동 유지

AI 활용이 뇌의 깊은 학습 기제를 차단함 14

학습 효과

얕은 인지 처리, 후속 회상 어려움 15

반복 인출 및 부호화 강화

즉각적 피드백이 장기 기억 형성을 방해함 15

생성형 AI를 활용한 글쓰기 과제에서 전문가 집단은 생산성이 향상된 반면, 초보자들은 AI의 결과물을 수정 없이 그대로 수용하는 경향이 강했습니다.11 이는 AI가 제공하는 '정답'에 매몰되어 인간의 고유한 문체나 비판적 시각이 사라지는 과정을 보여줍니다.16 교육 수준이 높을수록 이러한 인지적 위축에 대한 저항력이 강하다는 사실은, AI 시대에 역설적으로 인간 고유의 기초 학문과 사고 훈련이 더욱 중요해졌음을 의미합니다.8

효율성으로 환산할 수 없는 '경험'의 가치

AI 시스템의 핵심 논리는 '최적화'와 '효율성'입니다. 알고리즘은 가장 빠른 경로, 가장 정확한 답변, 가장 비용이 적게 드는 선택을 지향합니다.17 그러나 인간의 주체적인 삶에서 가중 중요한 가치들은 흔히 '비효율성'과 '불확실성' 속에 존재합니다. 현상학적 관점에서 볼 때, 인간의 지능은 기호의 조작이 아니라 신체적 존재로서 세계와 마주하며 겪는 '숙련된 대처(Skilled Coping)'에 기반합니다.19

허버트 드레이퍼스(Hubert Dreyfus)는 인간의 전문성이 규칙에 기반한 '계산적 지능'이 아니라, 상황의 맥락을 직관적으로 파악하는 '체화된 지능(Embodied Intelligence)'에서 나온다고 주장했습니다.21 AI는 방대한 데이터를 통해 인간의 판단을 흉내 낼 수 있지만, 그 과정에 담긴 '삶의 무게'나 '맥락적 의미'를 이해하지 못합니다.23 예를 들어, GPS가 안내하는 가장 빠른 길은 효율적일지 모르나, 그 과정에서 길을 잃고 헤매며 주변 풍경을 익히고 공간을 장악해가는 '공간적 경험'의 가치는 사라집니다.5 이러한 경험은 단순한 정보 습득이 아니라, 인간이 세계 속에서 자신의 자리를 확인하고 자율성을 확립해가는 실존적 과정입니다.20

토비아스 리스(Tobias Rees)는 AI가 아무리 똑똑해지더라도 "나를 대신해 똑똑할 수는 없다(cannot be smart for me)"고 지적합니다.23 통찰(Insight)이란 인간이 자신의 삶을 주도적으로 이끌어가기 위해 스스로 생각하고 깨닫는 과정이며, 이는 타인이나 기계에 의해 제공될 수 없는 지극히 주관적인 영역입니다.23 AI가 내리는 최적의 결정에 순응하는 삶은 효율적일지언정, 스스로 고민하고 선택하며 그 결과에 책임을 지는 인간 본연의 '살아있음'을 훼손할 위험이 큽니다.25

실패와 비효율성을 통해 획득되는 인간의 고유성

인간의 성장과 정체성 형성은 실패와 그 극복 과정에서 발생하는 '바람직한 어려움(Desirable Difficulties)'을 통해 완성됩니다.26 심리학적 관점에서 볼 때, 쉽게 얻은 정답은 뇌에 깊이 각인되지 않으며, 오히려 학습에 대한 착각을 불러일으킬 뿐입니다.26 반면, 고통스러운 시행착오와 실패는 뇌의 시냅스 연결을 강화하고, 문제를 해결할 수 있다는 '자기 효능감'을 형성하는 기반이 됩니다.27

'이케아 효과(IKEA Effect)'는 인간이 직접 노력을 기울여 만든 대상에 더 높은 가치를 부여하는 심리적 경향을 보여줍니다.29 이는 단순히 물건에 대한 애착을 넘어, 자신의 노력이 투입된 결과물을 통해 자신의 유능함을 확인하려는 본능적 욕구와 연결되어 있습니다.29 AI가 모든 과정을 대신 해주는 '마찰 없는(Frictionless)' 환경에서는 이러한 성취의 기쁨과 자아 확장의 기회가 원천적으로 차단됩니다.18

실패와 비효율성의 심리적·발달적 가치

개념

심리적 기제

주체성 형성에 미치는 영향

바람직한 어려움

의도적인 난관과 노력이 장기 기억과 이해를 도움

쉬운 정답에 안주하지 않는 도전 정신 함양 26

생산적 실패

실패를 통해 문제의 구조를 깊이 이해하는 과정

회복 탄력성과 창의적 문제 해결 능력 강화 27

이케아 효과

노동과 노력이 투입된 결과물에 대한 높은 가치 부여

자기 효능감과 정체성 확립에 기여 29

노력의 역설

고통스러운 노력이 오히려 보상적 가치를 가짐

외부 보상 없이도 스스로 행동하는 내적 동기 강화 32

심리사회적 위기 극복

갈등과 실패를 겪으며 자아 덕목(의지, 유능성) 획득

사회 속에서 통합된 자아 정체성 완성 33

에릭 에릭슨(Erik Erikson)의 자아 발달 단계에 따르면, 인간은 어린 시절부터 스스로 선택하고 실패하는 경험을 통해 '자율성'과 '유능감'을 획득합니다.33 부모나 사회가 모든 것을 대신 결정해주거나 실패를 원천 봉쇄할 때, 개인은 수치심과 회의에 빠지며 타인에게 과도하게 의존하는 성격으로 변모할 수 있습니다.33 AI에 모든 판단을 맡기는 사회적 분위기는 전 인류를 이러한 '발달적 퇴행' 상태로 몰아넣을 수 있다는 점에서 우려스럽습니다. 비효율성은 낭비가 아니라, 인간이 자신만의 독특한 삶의 서사를 써 내려가기 위해 지불해야 하는 필수적인 비용입니다.31

모든 판단을 AI에 맡길 때의 부정적 영향과 위협

모든 판단을 알고리즘에 위임하는 상황은 인간의 주체적 삶에 치명적인 위협을 가합니다. 첫째, '알고리즘적 결정론'에 의한 자율성 상실입니다. AI는 사용자의 과거 데이터를 기반으로 최적의 선택지를 제안하지만, 이는 인간이 자신의 과거로부터 벗어나 새로운 삶의 방식을 선택할 수 있는 '근본적 자유'를 제한합니다.25 특히 청소년기에 알고리즘이 큐레이션한 정보만을 접하게 되는 '알고리즘적 조기 마감(Algorithmic Foreclosure)'은 건강한 정체성 탐색을 방해하고 편협한 가치관을 고착화시킵니다.34

둘째, 도덕적 책임의 증발입니다. 장 폴 사르트르(Jean-Paul Sartre)의 실존주의에 따르면, 인간은 자신의 모든 선택에 대해 전적인 책임을 져야 합니다.25 AI의 판단이 '객관적'이고 '중립적'이라는 환상은 인간이 자신의 결정에 따르는 도덕적 무게를 회피하게 만드는 '기만(Bad Faith)'의 수단이 될 수 있습니다.25 알고리즘의 오류로 발생한 피해에 대해 누구도 책임지지 않는 상황은 사회적 신뢰를 파괴하고 인간을 책임의 주체에서 관리의 대상으로 전락시킵니다.25

셋째, 인간 존재의 도구화입니다. 마틴 하이데거(Martin Heidegger)가 경고한 '몰아세움(Gestell)'의 틀 속에서, 기술은 인간을 포함한 모든 존재를 효율성을 위해 대기하는 '부품(Standing-reserve)'으로 취급합니다.37 AI가 인간의 건강, 관계, 직업을 모두 최적화해주는 세상에서 인간은 스스로 목적을 설정하는 주권자가 아니라, 알고리즘이 설정한 목표치를 달성하기 위해 관리되는 자원일 뿐입니다.18 이는 인간의 존엄성과 노동의 가치를 훼손하며, 소수의 기술 소유자에게 권력이 집중되는 종속적 사회를 초래합니다.39

AI 의존에 따른 주체적 삶의 위기 요인

위기 유형

메커니즘

결과 및 우려

알고리즘적 자아

데이터 기반의 개인화된 피드백 루프 고착

내면의 목소리보다 외부 검증에 의존 40

인지적 타율성

알고리즘의 제안을 무비판적으로 수용

독립적 의사결정 및 가치 판단 능력 상실 42

도덕적 기만

AI의 판단을 방패 삼아 책임을 회피함

윤리적 감수성 저하 및 사회적 책임 공백 25

정체성 고착

알고리즘이 규정한 선호도 내에 갇힘

다양한 가능성의 탐색 차단 및 사고의 획일화 34

존재론적 위축

모든 문제를 기술적 해결의 대상으로 간주

삶의 신비와 도덕적 고뇌의 가치 소멸 38

결론: 인지적 주권 회복을 위한 제언

AI 시대에 인간의 주체성을 지키는 것은 기술의 사용을 전면 거부하는 것이 아니라, 기술과의 관계를 주체적으로 재설정하는 데 있습니다.2 우리는 AI가 제공하는 '최적화된 효율성'이 우리의 '사고하는 힘'을 갉아먹지 않도록 의식적인 노력을 기울여야 합니다.

첫째, 교육 현장에서는 AI의 답변을 비판적으로 검증하고, AI 없이도 문제를 해결할 수 있는 기초 체력을 기르는 '메타인지적 훈련'이 강화되어야 합니다.2 실패할 권리와 비효율적인 탐구의 가치를 존중하는 교육 문화가 정착되어야 합니다.27 둘째, 일상생활에서 모든 판단을 알고리즘에 맡기지 않는 '인지적 자립'의 공간을 확보해야 합니다.3 때로는 지도를 보지 않고 길을 찾고, 전화번호를 외우며, AI의 추천을 거부하고 낯선 선택을 하는 '불편함'을 의도적으로 수용해야 합니다.2

셋째, 기술 설계와 정책 측면에서 인간의 '유의미한 통제(Meaningful Oversight)'가 보장되어야 합니다.2 AI는 인간의 판단을 돕는 '파트너'여야지, 인간을 대신하는 '대리인'이 되어서는 안 됩니다.2 마지막으로, 우리는 비효율성과 실패가 우리를 더 인간답게 만든다는 사실을 잊지 말아야 합니다. 인간의 고유성은 알고리즘이 계산할 수 없는 고뇌와 선택, 그리고 그 결과에 대한 온전한 책임 속에서 비로소 완성되기 때문입니다.25 인지적 주권을 포기한 대가로 얻는 효율성은 영혼 없는 편리함에 불과하며, 인간다움을 유지하는 유일한 길은 끊임없이 스스로 생각하고 의심하며 스스로의 판단에 따라 행동하는 고단한 주체성의 길을 걷는 것입니다.

참고 자료

Perspective on the Role of AI in Shaping Human Cognitive Development - MDPI, 12월 28, 2025에 액세스, https://www.mdpi.com/2078-2489/16/11/1011

Reclaiming Cognitive Autonomy in the Age of AI, 12월 28, 2025에 액세스, https://www.cigionline.org/articles/reclaiming-cognitive-autonomy-in-the-age-of-ai/

Cognitive offloading: The brain and its digital helpers, 12월 28, 2025에 액세스, https://www.ergo.com/en/radar-magazine/digitalisation-and-technology/2025/cognitive-offloading-mental-performance-digital-helpers

A Meta-Analysis of Technology Use and Cognitive Aging - PMC - NIH, 12월 28, 2025에 액세스, https://pmc.ncbi.nlm.nih.gov/articles/PMC12333551/

(PDF) Distributed Atrophy 2.0: Cognitive Offloading and the ..., 12월 28, 2025에 액세스, https://www.researchgate.net/publication/394026188_Distributed_Atrophy_20_Cognitive_Offloading_and_the_Reshaping_of_Thought

Is AI dulling our minds? - Harvard Gazette, 12월 28, 2025에 액세스, https://news.harvard.edu/gazette/story/2025/11/is-ai-dulling-our-minds/

AI Tools in Society: Impacts on Cognitive Offloading and the Future of Critical Thinking, 12월 28, 2025에 액세스, https://www.mdpi.com/2075-4698/15/1/6

AI's cognitive implications: the decline of our thinking skills? - IE, 12월 28, 2025에 액세스, https://www.ie.edu/center-for-health-and-well-being/blog/ais-cognitive-implications-the-decline-of-our-thinking-skills/

(PDF) AI Tools in Society: Impacts on Cognitive Offloading and the Future of Critical Thinking, 12월 28, 2025에 액세스, https://www.researchgate.net/publication/387701784_AI_Tools_in_Society_Impacts_on_Cognitive_Offloading_and_the_Future_of_Critical_Thinking

Deskilling and upskilling with AI systems | Information Research an international electronic journal - Publicera, 12월 28, 2025에 액세스, https://publicera.kb.se/ir/article/view/47143

(PDF) Deskilling and upskilling with AI systems - ResearchGate, 12월 28, 2025에 액세스, https://www.researchgate.net/publication/389742059_Deskilling_and_upskilling_with_AI_systems

Deskilling and upskilling with generative AI systems - Citizen Science Research at Syracuse, 12월 28, 2025에 액세스, https://citsci.syr.edu/sites/default/files/GAI_and_skills.pdf

[2503.03924] De-skilling, Cognitive Offloading, and Misplaced Responsibilities: Potential Ironies of AI-Assisted Design - arXiv, 12월 28, 2025에 액세스, https://arxiv.org/abs/2503.03924

Is AI Eroding Our Critical Thinking Skills? - The ANSI Blog, 12월 28, 2025에 액세스, https://blog.ansi.org/ansi/is-ai-eroding-our-critical-thinking-skills/

Human-AI Interactions: Cognitive, Behavioral, and Emotional Impacts - ChatPaper, 12월 28, 2025에 액세스, https://chatpaper.com/paper/201172

Blog – The use of Generative AI in academia & higher education: friend or foe?, 12월 28, 2025에 액세스, https://www.dementiaresearcher.nihr.ac.uk/blog-the-use-of-generative-ai-in-academia-higher-education-friend-or-foe/

Philosophy of artificial intelligence - Wikipedia, 12월 28, 2025에 액세스, https://en.wikipedia.org/wiki/Philosophy_of_artificial_intelligence

Evgeny Morozov: 'We are abandoning all the checks and balances' - The Guardian, 12월 28, 2025에 액세스, https://www.theguardian.com/technology/2013/mar/09/evgeny-morozov-technology-solutionism-interview

Hubert Dreyfus on Practical and Embodied Intelligence* | 12 | The Rout - Taylor & Francis eBooks, 12월 28, 2025에 액세스, https://www.taylorfrancis.com/chapters/edit/10.4324/9781315180809-12/hubert-dreyfus-practical-embodied-intelligence-kristina-gehrman-john-schwenkler

Hubert Dreyfus on Practical and Embodied Intelligence* Kristina Gehrman and John Schwenkler Forthcoming in The Routledge Handboo, 12월 28, 2025에 액세스, https://kristina-gehrman.squarespace.com/s/Hubert-Dreyfus-on-Practical-and-Embodied-Intelligence.pdf

Hubert Dreyfus's views on artificial intelligence - Wikipedia, 12월 28, 2025에 액세스, https://en.wikipedia.org/wiki/Hubert_Dreyfus%27s_views_on_artificial_intelligence

Hubert Dreyfus's views on artificial intelligence - Grokipedia, 12월 28, 2025에 액세스, https://grokipedia.com/page/Hubert_Dreyfus's_views_on_artificial_intelligence

Why AI Is A Philosophical Rupture - Noema Magazine, 12월 28, 2025에 액세스, https://www.noemamag.com/why-ai-is-a-philosophical-rupture/

Artificial Intelligence vs. Human Intelligence: A Philosophical Perspective - New Acropolis Library, 12월 28, 2025에 액세스, https://library.acropolis.org/artificial-intelligence-vs-human-intelligence-a-philosophical-perspective/

Sartre's Existentialism in the Age of Artificial Intelligence – Analysis - Eurasia Review, 12월 28, 2025에 액세스, https://www.eurasiareview.com/20112024-sartres-existentialism-in-the-age-of-artificial-intelligence-analysis/

Desirable difficulty - Wikipedia, 12월 28, 2025에 액세스, https://en.wikipedia.org/wiki/Desirable_difficulty

Growth Mindset Interventions to Make Failure Desired in Learning - ISLS Repository, 12월 28, 2025에 액세스, https://repository.isls.org/bitstream/1/11391/1/ICLS2025_191-199.pdf

Failure is the Only Option: Embracing a Growth Mindset - TargetX, 12월 28, 2025에 액세스, https://www.targetx.com/blog/failure-is-the-only-option-embracing-a-growth-mindset/

IKEA Effect - The Decision Lab, 12월 28, 2025에 액세스, https://thedecisionlab.com/biases/ikea-effect

IKEA effect - Wikipedia, 12월 28, 2025에 액세스, https://en.wikipedia.org/wiki/IKEA_effect

The IKEA Effect: Do Hard Things | The Curiosity Chronicle - Sahil Bloom, 12월 28, 2025에 액세스, https://www.sahilbloom.com/newsletter/the-ikea-effect-do-hard-things

The Effort Paradox: Effort Is Both Costly and Valued - PMC - NIH, 12월 28, 2025에 액세스, https://pmc.ncbi.nlm.nih.gov/articles/PMC6172040/

Erik Erikson's Stages of Psychosocial Development Explained - Positive Psychology, 12월 28, 2025에 액세스, https://positivepsychology.com/erikson-stages/

How Social Media Algorithms Impact Identity Exploration in Adolescents Ages 12-16, 12월 28, 2025에 액세스, https://www.researchgate.net/publication/398561241_The_Algorithmic_Looking_Glass_How_Social_Media_Algorithms_Impact_Identity_Exploration_in_Adolescents_Ages_12-16

Existentialist Humanism: Sartre's Freedom-Based Ethics - Philosophy Institute, 12월 28, 2025에 액세스, https://philosophy.institute/ethics/sartres-existentialist-humanism-ethics/

An Existentialist Philosophical Perspective on the Ethics of ChatGPT Use | Indonesian Journal of Advanced Research - Formosa Publisher, 12월 28, 2025에 액세스, https://journal.formosapublisher.org/index.php/ijar/article/view/14989/14110

The Question Concerning Technology - Wikipedia, 12월 28, 2025에 액세스, https://en.wikipedia.org/wiki/The_Question_Concerning_Technology

Books For Designers: “The Question Concerning Technology”, by Martin Heidegger (1954) | by Jeff Appel | Medium, 12월 28, 2025에 액세스, https://medium.com/@jeff.appel/the-question-concerning-technology-by-martin-heidegger-1954-22c03bcdeb20

AI, work, and dignity: Why the future of labour is a question of justice, not hours - Organiser, 12월 28, 2025에 액세스, https://organiser.org/2025/12/24/331766/bharat/ai-work-and-dignity-why-the-future-of-labour-is-a-question-of-justice-not-hours/

The algorithmic self: how AI is reshaping human identity, introspection, and agency, 12월 28, 2025에 액세스, https://www.frontiersin.org/journals/psychology/articles/10.3389/fpsyg.2025.1645795/full

How Do Algorithms Influence Personal Identity and Choice? → Question - Lifestyle → Sustainability Directory, 12월 28, 2025에 액세스, https://lifestyle.sustainability-directory.com/question/how-do-algorithms-influence-personal-identity-and-choice/

AI Systems and Respect for Human Autonomy - PMC, 12월 28, 2025에 액세스, https://pmc.ncbi.nlm.nih.gov/articles/PMC8576577/

(PDF) A Social-Psychological Study on the Impact of Short Video Platform Algorithms on Adolescents' Self-Identity Construction - ResearchGate, 12월 28, 2025에 액세스, https://www.researchgate.net/publication/394736824_A_Social-Psychological_Study_on_the_Impact_of_Short_Video_Platform_Algorithms_on_Adolescents'_Self-Identity_Construction

“Enframing” Modernity: Heidegger, Technology, and the Human Condition, 12월 28, 2025에 액세스, https://jamescungureanu.com/2024/12/30/enframing-modernity-heidegger-technology-and-the-human-condition/

제2장. 판단의 상실: AI 의존으로 위협받는 인간의 주체성

I. 인지적 외주화의 함정: 도구가 앗아간 인간의 기능

1.1. 역사적 반복: 기술적 편의와 신체·지능의 퇴화

인류 문명에서 도구의 발달은 필연적으로 인간의 특정 능력을 외부로 전이시키는 ‘인지적 오프로딩(Cognitive Offloading)’을 동반해 왔습니다.1 자동차의 보급이 인간의 보행 능력을 감퇴시키고, 휴대전화의 등장이 수백 개의 전화번호를 외우던 암기력을 앗아갔으며, GPS 내비게이션이 길을 스스로 탐색하고 공간을 구조화하는 능력을 약화시킨 것이 대표적인 사례입니다.2 이러한 도구들은 특정 작업의 효율성을 높여주었으나, 동시에 해당 기능을 수행하던 뇌의 신경망을 유휴 상태로 만들어 인지적 위축을 초래했습니다.2

1.2. '분산된 위축 2.0' 모델: 사고 프로세스의 전이

최근 제안된 분산된 위축 2.0(Distributed Atrophy 2.0) 모델은 현대의 인공지능(AI)이 과거의 도구들과 질적으로 다른 위협을 가하고 있음을 경고합니다.2 과거의 기술이 기억이나 계산 같은 ‘결과값’을 보조했다면, 생성형 AI와 의사결정 알고리즘은 인간의 ‘추론 과정’ 자체를 대체합니다.4 인간은 본래 에너지를 아끼려는 ‘인지적 구두쇠(Cognitive Miser)’의 특성을 지니고 있어, AI가 제공하는 즉각적인 정답에 길들여질수록 스스로 개념을 추상화하고 논리를 조립하는 고통스러운 과정을 회피하게 됩니다.2 이러한 습관적 의존은 결국 비판적 사고력과 문제 해결 능력의 전반적인 침식으로 이어집니다 .

II. 알고리즘적 최적화 vs. 인간의 고유성

2.1. '최선'이라는 이름의 획일성

AI 시스템의 핵심 논리는 데이터에 기반한 ‘최적화(Optimization)’와 ‘효율성’입니다.7 알고리즘은 수많은 사례 중 통계적으로 가장 높은 확률의 정답을 제시하지만, 인간의 삶에서 마주하는 수많은 선택에는 모두에게 적용되는 단 하나의 '정답'이 존재하지 않습니다 . 삶의 가치는 각자가 가진 고유한 맥락과 가치관에 따라 주관적으로 형성되기 때문입니다.9 AI가 내리는 ‘최적의 결정’에 순응하는 삶은 효율적일지 모르나, 그 과정에서 개인이 가진 독특한 취향과 고유한 삶의 서사는 알고리즘의 평균값 아래로 매몰될 위험이 큽니다.10

2.2. 체화된 지능(Embodied Intelligence)의 부재

철학자 허버트 드레이퍼스(Hubert Dreyfus)는 인간의 지능이 단순히 기호를 조작하는 능력이 아니라, 신체를 가지고 세계와 부딪히며 얻는 ‘숙련된 대처(Skilled Coping)’와 직관에 기반한다고 주장했습니다.13 AI는 방대한 데이터를 흉내 낼 수는 있지만, 인간이 실제 경험을 통해 얻는 맥락적 이해와 '삶의 무게'를 담은 통찰은 가질 수 없습니다.16 AI가 정보를 제공할 수는 있어도, 그 정보가 개인의 삶에서 어떤 의미를 갖는지 깨닫는 ‘통찰(Insight)’의 과정은 오직 인간만이 수행할 수 있는 주체적인 영역입니다.9

III. 비효율성의 가치: 실패를 통해 완성되는 자아

3.1. ‘바람직한 어려움’과 자기 효능감

심리학적 관점에서 인간의 성장은 ‘바람직한 어려움(Desirable Difficulties)’을 극복하는 과정에서 발생합니다.18 마찰 없이 즉각적으로 얻은 정답은 장기 기억으로 전이되지 않으며, 오히려 학습에 대한 착각만을 불러일으킵니다.18 반면, 고통스러운 시행착오와 실패는 뇌의 시냅스 연결을 강화하고, "나는 문제를 해결할 수 있다"는 강력한 자기 효능감을 형성하는 토대가 됩니다.17 AI가 모든 마찰을 제거해 주는 환경은 아이들이 이러한 성취의 기쁨과 자아 확장의 기회를 박탈당하게 만듭니다.22

3.2. 이케아 효과(IKEA Effect)와 정체성 형성

인간은 스스로의 노력이 투입된 결과물에 더 높은 가치를 부여하는 ‘이케아 효과’를 보입니다.24 직접 가구를 조립하고, 길을 헤매고, 갈등을 조정하며 보낸 ‘비효율적인 시간’들이 모여 ‘나의 삶’이라는 고유한 정체성을 구성합니다.24 모든 판단과 행동을 효율적인 AI에게 맡기는 것은, 역설적으로 자신의 삶을 의미 있게 만드는 수고로움을 포기하는 것과 같습니다.27 실패와 비효율성은 낭비가 아니라, 인간이 자신만의 독특한 자아를 획득하기 위해 지불해야 하는 필수적인 비용입니다.23

IV. 책임의 외주화: 기술이라는 이름의 기만

4.1. 실존적 자유와 책임의 회피

장 폴 사르트르(Jean-Paul Sartre)의 실존주의에 따르면, 인간은 자신의 모든 선택에 대해 책임을 져야 하는 ‘자유라는 형벌’에 처해 있습니다 . AI의 판단이 객관적이고 중립적이라는 믿음은, 개인이 자신의 결정에 따르는 도덕적 무게를 회피하게 만드는 ‘기만(Bad Faith)’의 수단이 될 수 있습니다.28 "AI가 추천해서 선택했다"는 변명은 주체적인 판단을 포기하고 자신을 환경에 종속된 부품으로 전락시키는 행위입니다.28

4.2. 인지적 주권의 상실과 대안적 미래

모든 판단을 알고리즘에 위임할 때, 인간은 더 이상 삶의 주권자가 아니라 관리되는 ‘자원’으로 전락합니다.22 스스로 생각하는 능력을 상실한 세대는 AI의 오류를 감지하거나 기술이 설정한 경로 밖의 대안을 상상할 수 없게 됩니다 . 따라서 우리가 아이들에게 친구들과 부딪히고 실패하며 노는 ‘15분 놀이 도시’를 제공하려는 비전은 단순히 과거로의 회귀가 아닙니다. 그것은 다가올 AI 시대에 기술에 종속되지 않고, 기술을 도구로서 주체적으로 다룰 수 있는 **‘인지적 주권’**을 갖춘 인간을 길러내기 위한 가장 강력한 미래 전략입니다.32